- Подтверждено: по вине «автопилота» Tesla погибло уже четыре человека

- Жертвы автопилота Tesla Model 3

- Раскрыта тайна смертельного наезда беспилотника Uber

- Искусственный интеллект начал убивать на дорогах. Что произошло, кто виноват и стоит ли теперь бояться ИИ на колесах

- Что произошло?

- Случай с Tesla

- Uber über alles?

- Когда беспилотные автомобили действительно начнут массово убивать людей?

- Тот самый часто задаваемый вопрос

Подтверждено: по вине «автопилота» Tesla погибло уже четыре человека

Как стало известно из нового отчета Национального совета по безопасности транспорта США, седан Tesla Model 3, который в марте врезался в грузовик на шоссе Флориды и убил своего водителя, действовал с активной функцией автопилота. Этот водитель стал по меньшей мере четвертым погибшим в аварии, связанной с функцией полуавтономного вождения Tesla. Что поражает в катастрофе от 1 марта, так это то, что детали аварии почти идентичны деталям первого публичного сообщения о смертельной аварии автопилота в мае 2016 года.

В каждом случае Tesla на автопилоте сталкивается с грузовиком, пересекающим путь, и убивает водителя.

Жертвы автопилота Tesla Model 3

CEO компании Илон Маск похвастался способностями самоуправления своих автомобилей и пообещал, что в следующем году они станут полностью автономными. Но критики говорят, что система автопилота — которая требует, чтобы водители были начеку и готовы взять на себя управление автомобилем — работает недостаточно хорошо, чтобы держать водителей в узде, и что Tesla выдает систему как более способную, чем она есть на самом деле. Новая авария ставит под сомнение то, насколько хорошо Tesla отреагировала на эту критику, учитывая ее активное продвижение более амбициозных технологий.

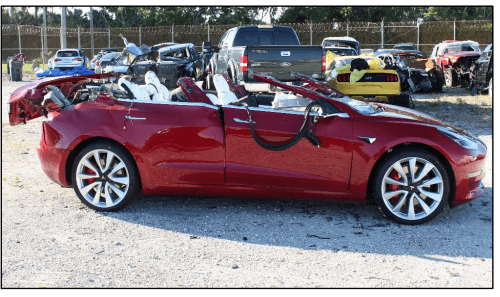

В мартовской аварии красная Tesla Model 3 ехала на юг по правой полосе государственного шоссе 441 в Делрей-Бич, примерно в 110 км к северу от Майами. Грузовик выехал с частной дороги на правой стороне шоссе, намереваясь повернуть налево и направиться на север. В отчете говорится, что грузовик замедлил движение, пересекая полосу, «заблокировав путь Tesla».

Система Autopilot на Model 3 включилась примерно за 10 секунд до аварии и автомобиль не видел рук водителя на руле в течение восьми секунд, непосредственно предшествующих удару. Представитель Tesla это подтверждает. Автомобиль врезался в трейлер на скорости 110 км/ч (при ограничении скорости в 90 км/ч), не пытаясь осуществить никаких маневров с целью уклонения. Автомобиль проехал под грузовиком, оторвав крышу и убив водителя Джереми Берен Бэннера, возрастом 50 лет. Водитель грузовика не пострадал.

В отчете не сообщается, как далеко находилась Tesla, когда грузовик выехал на дорогу, и не отмечаются погодные условия, которые могли бы повлиять на способность автомобиля затормозить. Поэтому неясно, смог бы водитель, не использующий автопилот, остановиться безопасно. Грубая математика подсказывает, что водителю Model 3 потребовалось бы несколько секунд, чтобы оценить обстановку и избежать аварии. На заданной скорости автомобиль проезжает 30 метров в секунду. Тормозной путь Model 3 на скорости 100 км/ч составляет около 40 метров. Автомобиль мог остановиться за 75 метров. Добавим 1,5 секунды на действия водителя по торможению и, похоже, трех секунд вполне хватило бы.

7 мая 2016 года 40-летний Джош Браун погиб при очень похожих обстоятельствах. Его Model S работала на автопилоте, когда он ехал на север по шоссе 27А в северной Флориде. Навстречу выехал грузовик. Tesla не остановила движение и врезалась на скорости 125 км/ч (при ограничении в 110 км/ч), прошла под грузовиком, сорвала крышу и убила Брауна. Затем машина проехала еще 100 метров, достаточно сильно ударилась о столб и через 15 метров остановилась. Водитель грузовика не пострадал.

Тогда стало очевидно, что водитель грузовика должен был уступить Tesla, а Браун был невнимательным. Но некоторая часть вины возлагается и на Tesla, которая позволяла водителю чрезмерно полагаться на систему автоматизации в течение длительного периода.

После смерти Брауна Tesla сократила время, в течение которого водитель может не касаться руля, прежде чем система выдаст звуковые и визуальные предупреждения. Сменила несколько итераций аппаратного и программного обеспечения. Но обстоятельства аварии указывают на то, что при движении на высокой скорости система по-прежнему не способна обнаруживать некоторые стационарные объекты или объекты, движущиеся перпендикулярно автомобилю. Вероятно, по этой же причине по крайней мере три Tesla врезались в стоящие пожарные машины в 2018 году (без серьезных травм).

Model 3, которая попала в последнюю аварию, была оснащена камерами, которые должны были, теоретически, обнаружить грузовик, пересекающий путь машины. Tesla не ответила на запрос Wired о том, как система использует радар и камеры или какие шаги были предприняты во избежание подобного рода аварий.

В то же время Tesla оптимистично относится к возможностям компьютерного зрения на базе камеры, которые должны позволить «полное самостоятельное вождение», по мнению Маска, без необходимости человеческого наблюдения. Еще в прошлом месяце руководитель технического отдела Tesla Autopulot Андрей Карпати заявил, что Tesla считает, что может использовать методы машинного обучения и камеры, чтобы сделать свои автомобили первоклассными водителями. Маск пошел еще дальше и заявил: «Я вполне уверенно предсказывают появление автономных роботакси у Tesla в следующем году».

А как думаете вы, получится у Tesla реализовать свое обещание? Расскажите свое мнение в нашем чате в Телеграме.

Источник статьи: http://hi-news.ru/auto/podtverzhdeno-po-vine-avtopilota-tesla-pogiblo-uzhe-chetyre-cheloveka.html

Раскрыта тайна смертельного наезда беспилотника Uber

Напомним, в марте прошлого года беспилотник Volvo XC90, который тестировали в Uber, сбил 49-летнюю Элейн Херцберг, которая переходила дорогу в неположенном месте, толкая рядом с собой велосипед.

После наезда пострадавшую доставили в больницу, где она скончалась от полученных травм. Это ДТП стало первым в истории случаем гибели человека при наезде беспилотного автомобиля. Из-за этой аварии компания Uber приостановила испытания беспилотных машин.

Впрочем, прокуратура сняла ответственность за ДТП с компании. Однако расследование ее причин NTSB продолжила.

Как пишет auto.news.com со ссылкой на N+1, опубликованный NTSB набор включает 40 документов, в которых содержатся свежие детали происшествия. В частности, один из них описывает работу созданных в Uber алгоритмов обнаружения и классификации объектов на дороге.

При оснащении самого безопасного кроссовера системами для автономной езды инженеры Uber отключили штатную систему экстренного торможения, внедрив собственную, которая активировалась в беспилотном режиме и имела секундную задержку, во время которой алгоритм убеждается в опасности ситуации, а также рассчитывал путь возможного объезда препятствия.

Такая задержка позволила решить проблему ложных срабатываний системы. Еще одна особенность в том, что алгоритмы были обучены распознавать пешеходов только рядом с пешеходными переходами, а в остальных случаях программа относила их к транспортным средствам или неопознанным объектам. При этом если объект признавался транспортным средством, то алгоритм предсказывал его траекторию в соответствии с одним из базовых сценариев. Если он считает пешехода неопознанным объектом, то вовсе не занимается расчетом траектории его движения.

Из-за этих особенностей перед наездом алгоритм, увидевший женщину за 5,6 секунды до столкновения, не смог опознать в ней пешехода и потратил время на то, чтобы отнести ее к тому или иному классу объектов. При этом менял класс несколько раз.

В итоге алгоритм определил женщину с велосипедом как велосипед за 1,2 секунды до наезда, а торможение из-за предусмотренной разработчиками задержки началось за 0,2 секунды. То есть наезд был неизбежен.

В материалах NTSB отмечается, что за прошедшее с момента аварии время в Uber переработали используемые алгоритмы. Согласно расчетам, при повторении ситуации обновленные алгоритмы среагировали бы лучше, и автомобиль начал бы тормозить более чем на четыре секунды раньше.

Напомним, что Uber возобновил испытания беспилотников на дорогах общего пользования в декабре 2018 года.

Источник статьи: http://rg.ru/2019/11/10/raskryta-tajna-smertelnogo-naezda-bespilotnika-uber.html

Искусственный интеллект начал убивать на дорогах. Что произошло, кто виноват и стоит ли теперь бояться ИИ на колесах

Что произошло?

Поздним вечером 18 марта женщина переходила дорогу вместе со своим велосипедом. Ехавший по той же улице автомобиль Uber, оснащенный лидаром (лазерный аналог радара) и иным оборудованием для беспилотного вождения, сбил женщину, после чего ее доставили в больницу, где она умерла. Находившийся в машине инженер Uber не успел вовремя вмешаться, перехватить управление и предотвратить трагедию. По всей видимости, он так же не успел заметить пешехода. Двигался в этот момент автомобиль на скорости 64 км/ч.

Убить пешехода из-за плохой видимости машина не могла: хотя было еще темно, но для лидара это незначимый фактор. В теории на его способность «видеть» мог негативно повлиять дождь или плотный туман, отражающий и рассеивающий лазерные лучи, но в то время в Темпе не наблюдалось ни того ни другого.

Глава полиции Темпе Сильвия Мойр (Sylvia Moir) в интервью San Francisco Chronicle заявила, что скорее всего в случившемся виновна сама велосипедистка. По словам Мойр, та нагрузила на велосипед пластиковые сумки и переходила в стороне от обозначенного пешеходного перехода. Кроме того, она ступила на дорогу с островка безопасности между полосами движения внезапно, прямо перед проезжающей машиной, то есть отреагировать в таких обстоятельствах даже водителю-человеку было бы практически невозможно.

Чтобы полностью понять значение инцидента, стоит напомнить два факта. Во-первых, до сих пор в ДТП со смертельным исходом беспилотники не участвовали ни разу. Во-вторых, беспилотная программа Uber уже подвергалась сильнейшей критике в связи с нарушениями ее автопилотом правил дорожного движения (езды на красный в присутствии пешеходов и так далее).

Случай с Tesla

В 2016 году автомобиль Tesla Model S попал в ДТП, которое в российских СМИ и вообще в русскоязычном сегменте интернета неверно расценили как первое событие с летальным исходом по вине автопилота. Однако на самом деле это не так. Tesla Model S, согласно руководству водителя, на данном этапе предлагает только продвинутую систему круиз-контроля, при пользовании которой водитель должен быть всегда готов перехватить управление и держать руки на руле. Машина погибшего в 2016 году водителя подавала ему звуковые сигналы о том, что он убрал руки с руля, однако тот не реагировал и продолжал смотреть «Гарри Поттера».

Tesla Model S действительно не распознала белый грузовик на фоне неба, отчего машина проехала под ним, убив водителя. Однако даже представители американских властей (NHTSA), обычно скорые на расправу, не смогли утверждать, что в ДТП виноват автомобиль — однозначное указание в руководстве водителя и отсутствие у Tesla рекламы, эксплуатирующей слово «автопилот» (впрочем, у данной компании вообще пока не было коммерческой рекламы), делало такое заявление невозможным.

Дополнительным фактором, не давшим применить санкции к Tesla, была переданная ее менеджерами властям статистика по логам езды в режиме продвинутого круиз-контроля. Оказалось, что к октябрю 2016 года в таком режиме машины Tesla проехали уже 357 миллионов километров, и это летальное ДТП было первым.

Дело в том, что в среднем в США на 357 миллионов километров пробега легкового автомобиля приходится 2,3 смерти, а, например, в России — около семи. Более того, расследование властей показало, что после внедрения на Tesla Model S такого продвинутого круиз-контроля общее число серьезных аварий на километр пробега упало для этих машин на 40 процентов. Под серьезной аварией доклад NHTSA имел в виду такую, при которой от удара раскрываются подушки безопасности. То есть получалось, что даже до развертывания полноценного автопилота уже внедренный «частичный автопилот» резко повысил безопасность водителей.

Странная трактовка происшествия в российских СМИ («первая смерть на счету беспилотного авто») была вызвана слабым знакомством с темой отечественных автомобильных журналистов. Они буквально перевели слово Autopilot (коммерческое наименование продвинутого круиз-контроля Tesla) как «автопилот». Ни в доступное в сети руководство для владельцев электромобилей, ни на сайт компании, описывающей сущность этого «автопилота», никто не заглянул. Также прошел мимо внимания российской прессы и тот факт, что сама Tesla неоднократно отмечала: действительно, беспилотный режим будет доступен на ее машинах лишь после соответствующего программного апдейта, о котором будет сообщено дополнительно (сейчас он планируется на 2018—2019 годы).

Uber über alles?

Программа развертывания беспилотников Uber с самого начала резко отличалась от всех остальных. Например, она была не похожа на Tesla тем, что позиционировала свои машины как беспилотные такси.

Проблемы начались с того, что компания очень поздно — на три-четыре года позже конкурентов, что для этого сектора просто целая эпоха, — пришла на рынок беспилотников. Поэтому Uber сильно технологически отставал от лидеров гонки Waymo (принадлежит Google) и Tesla. Чтобы как-то догнать их, Uber пошел на шаги, не совсем законные с точки зрения американского права. Компания купила стартап Otto, созданный бывшими сотрудниками Google, ушедшими из компании с целью создать свой беспилотник. Waymo ожидаемо подало в суд, обвинив Uber в банальном воровстве технологий. Последний даже не стал судиться — тут же пошел на мировую и отдал Waymo 244 миллионов долларов в качестве компенсации.

Но желание любой ценой догнать уходящий вперед поезд прогресса не оставляло Uber. Компания начала тестировать свои беспилотники на дорогах Калифорнии. Один из них почти тут же попал на камеру едущим на красный свет, причем рядом с пешеходом, переходившим дорогу по всем правилам. Uber попытался спасти лицо, заявив, что в этот момент управление беспилотником перехватил ее инженер и что сама машина «не виновата». Правда, другие источники тут же недвусмысленно указали, что это неправда и разработчики просто выгораживают свое пока еще сырое детище.

Власти Калифорнии немного устали от подобной ситуации — с машинами Waymo у них таких проблем не было, те на красный свет не ездили. Поэтому получить разрешение на испытания своих беспилотников на дорогах общего пользования в данном штате Uber стало затруднительно, и компания перенесла свои испытания в Аризону. Там и случилась первая смерть с участием ее автопилота. Теперь компания вовсе приостановила программу испытаний.

Когда беспилотные автомобили действительно начнут массово убивать людей?

В целом беспилотные машины пока трудно назвать опасными: как ни считай, они убивают намного меньше людей на километр пробега, чем средний водитель-человек. Достаточно напомнить, что автомобили Waymo, например, проехали три миллиона километров в беспилотном режиме уже к 2016 году — и не имели ни одного ДТП со смертельным исходом. Данные по частичному «автопилоту» Tesla мы приводили выше — они еще более впечатляющие. Другое дело, что автопилот автопилоту рознь, и у Uber статистика смертельных ДТП близка к начинающим водителям-людям, то есть радикально хуже.

Однако в самом ближайшем будущем ситуация с числом жертв беспилотников начнет меняться. В 2018—2019 годах Tesla планирует проапгрейдить программное обеспечение на всех своих машинах, которых уже сейчас больше 200 000, а к тому времени будет уже больше 300 000. Апгрейд позволит полностью использовать возможности уже установленного на машинах оборудования для беспилотного вождения. Массовое внедрение, несомненно, будет сопровождаться ошибками, пусть и более редкими, чем у людей. В этот момент летальные ДТП по вине беспилотников будут случаться все чаще и чаще, просто потому, что парк Tesla растет очень быстро. И такая печальная статистика просто неизбежна.

Тот самый часто задаваемый вопрос

Самый частый вопрос в связи с гибелью человека от рук роботов — кто виноват? От ответа зависит и то, кто будет платить по страховке, разоряться в суде и многое другое. С данным конкретным случаем все, кажется, ясно: виновным, скорее всего, определят пешехода. Однако очевидно, что рано или поздно будет и такое событие, в котором причиной гибели будет ошибка беспилотного авто. С юридической точки зрения виновником в этом случае будет производитель оборудования, но только если он не оговорил отказ от ответственности так же, как это делает, например, операционная система Windows.

Если из-за «синего экрана» компьютера под ее управлением отключится свет в больнице и хирург не сможет спасти пациента, то в силу принятия пользовательского соглашения при установке системы Microsoft ответственности не несет. Отраслевые наблюдатели уже давно ожидают подобных превентивных мер юридической защиты от тех, кто создает автопилоты. Вероятно, мы увидим такие соглашения уже в ближайшие пару лет.

Ну, а если обратиться не к праву, а к совести, то конечно же в сложном программном продукте с миллионами строк кода ошибки неизбежны. Конечно же, в ошибках на самом деле — по совести — виноваты программисты компаний-разработчиков автопилотов. Но вот обвинять их всерьез, по той же совести, будет трудновато. Как бы плохо ни работали программисты, мы, водители, судя по статистике, водим все равно хуже.

Александр Березин

Источник статьи: http://tass.ru/tech/6820436